Fernanda Durán

El Congreso del Estado llevó a cabo la mesa IA y Democracia: regulación ética y desafíos electorales, en la cual especialistas académicos, periodistas y legisladores coincidieron en que la inteligencia artificial (IA) ya transformó el ecosistema electoral y que México enfrenta rezagos en regulación, infraestructura tecnológica y alfabetización digital para afrontar fenómenos como deepfakes, microsegmentación política y manipulación algorítmica.

El eje de la discusión se centró en los efectos reales de la IA sobre la integridad democrática, la propagación de noticias falsas y la urgencia de crear lineamientos claros antes del próximo proceso electoral.

El doctor José Ignacio Núñez Varela, especialista en IA y profesor investigador de la Universidad Autónoma de San Luis Potosí (UASLP), advirtió que el debate debe partir de un diagnóstico honesto sobre la capacidad tecnológica del país y sobre la velocidad con la que la desinformación se expande.

Señaló que la IA ya intensificó prácticas históricas de manipulación: “Antes quería gente que fuera más especialista, ahora es muy fácil de que, prácticamente, cualquier persona al alcance con una computadora en las manos, puede hacerlo”.

Núñez explicó que el principal riesgo es estructural: herramientas generativas permiten crear videos, audios y fotografías falsas que circulan más rápido de lo que las instituciones pueden reaccionar.

Por ello, insistió en que el primer paso es la alfabetización algorítmica, es decir, enseñar a la ciudadanía cómo funcionan estos sistemas para que puedan detectar engaños.

“Porque se puede prohibir y se puede decir que no se debe de hacer, pero de eso a que no lo haga la gente, pues va a ser muy complicado”.

Otro de los puntos centrales del especialista fue la falta de confianza pública en los procesos electorales. Si hoy persiste la desconfianza incluso con sistemas físicos y verificables, digitalizar totalmente el proceso sin reglas claras podría agravar la incertidumbre.

Núñez insistió en que cualquier implementación de IA debe ser transparente, explicable y auditada, de forma que la ciudadanía pueda observar cada paso del procedimiento. De lo contrario, la tecnología podría terminar perjudicando más que ayudar.

Respecto a la reforma ya aprobada por el Congreso sobre la manipulación de videos mediante IA, el investigador consideró que sí era necesaria.

“Se necesita regular desde muchos tipos de aspectos como les decía, desde el inicio, que ahorita ya vamos tarde, desde el desarrollo de ese tipo de herramientas. Desde ese punto de vista no se ha hecho la regulación, por lo tanto se ha dejado que las empresas puedan desarrollar cualquier tipo de aplicaciones sin tener en conciencia de lo que pudieran alcanzar a tener el alcance que tienen ese tipo de herramientas”.

También aclaró que, en su lectura, la iniciativa estatal no vulnera la libertad de expresión porque excluye parodias, sátira y usos no maliciosos de contenido digital. Sin embargo, cualquier legislación local o nacional enfrenta un límite inevitable: las empresas que operan estos modelos se ubican fuera del país.

“Aunque en Europa ya se tengan ciertas reglas, si la empresa se encuentra localizada en otro país, pues las reglas no se aplican”.

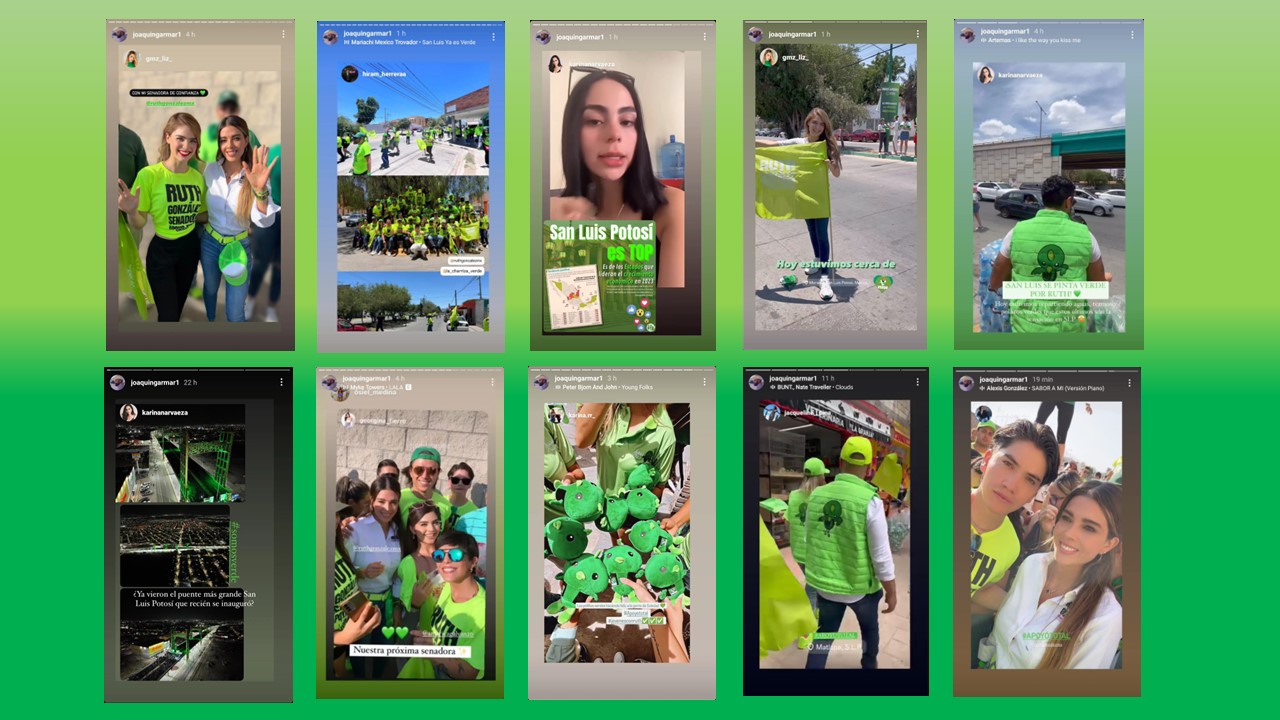

En la presentación de la mesa, el diputado Carlos Arreola Mallol recordó que fenómenos globales como Cambridge Analytica demostraron cómo los algoritmos pueden alterar la opinión pública mediante la microsegmentación de contenidos.

También mencionó los casos recientes en los que la polarización no se origina necesariamente en la disputa política, sino en “los actores algorítmicos que influyen en nuestro día a día”.

Los ponentes coincidieron en tres desafíos principales:

La desinformación como amenaza inmediata, en la que se recalcó que los deepfakes y audios manipulados pueden estallar en vísperas de una elección, sin que exista un protocolo institucional que permita desmentir rápidamente la información falsa.

Segundo, en la necesidad de lineamientos y protocolos en tiempo real. Los especialistas señalaron que las autoridades electorales deben contar con mecanismos capaces de actuar más rápido que la propagación de contenido manipulado.

Finalmente, la alfabetización digital para fortalecer la capacidad crítica del electorado. Según advirtieron, los ataques de desinformación no desaparecerán, por lo que la ciudadanía debe saber reconocer señales de manipulación, verificar fuentes y comprender limitaciones de los sistemas generativos.

Durante el desarrollo del foro, el periodista Jesús Aguilar anunció la presentación de una iniciativa enfocada en aquello que considera aún tiene huecos la legislación local, con ello se espera que “podamos terminar usando esta gran herramienta también como un motor de una nueva armonización en este torrente de información universal, que hoy representa la era digital y la inteligencia artificial”.