Fernanda Durán

El académico brasileño Rodrigo Florencio da Silva, investigador del Instituto Politécnico Nacional (IPN), sostuvo en San Luis Potosí que la inteligencia artificial (IA) no es un fenómeno repentino, sino el resultado de décadas de desarrollo tecnológico, pero su uso sin control y sin ética puede amplificar la desinformación, manipular procesos democráticos y profundizar la desigualdad.

Ante este contexto, planteó que antes de centrarse sólo en sanciones penales, los estados deben apostar por la formación ciudadana, la transparencia y marcos regulatorios claros.

En entrevista previa a su conferencia magistral “Horizontes, oportunidades y riesgos de la Inteligencia Artificial en el Sector público”, en el Congreso del Estado, Florencio recordó que “muchas veces pensamos que es algo nuevo, pero si hablamos de inteligencia artificial, nosotros estamos hablando desde los experimentos de Turing de 1950 más o menos”.

Subrayó que hoy la diferencia es que la tecnología “está de acceso a todos”, y si ese uso es “sin freno” y “sin responsabilidad”, puede convertirse en una herramienta de daño, a partir de ello dijo, la importancia de contar con “normas, leyes” y, al mismo tiempo, de impulsar procesos de sensibilización que comiencen desde las escuelas.

El especialista insistió en que el reto central no es sólo técnico, sino formativo. “Primero yo digo que el reto es formar (…) que justamente las personas no van a utilizar esas herramientas diciendo va a salvar la vida. No. Es importante justamente tener un uso consciente”.

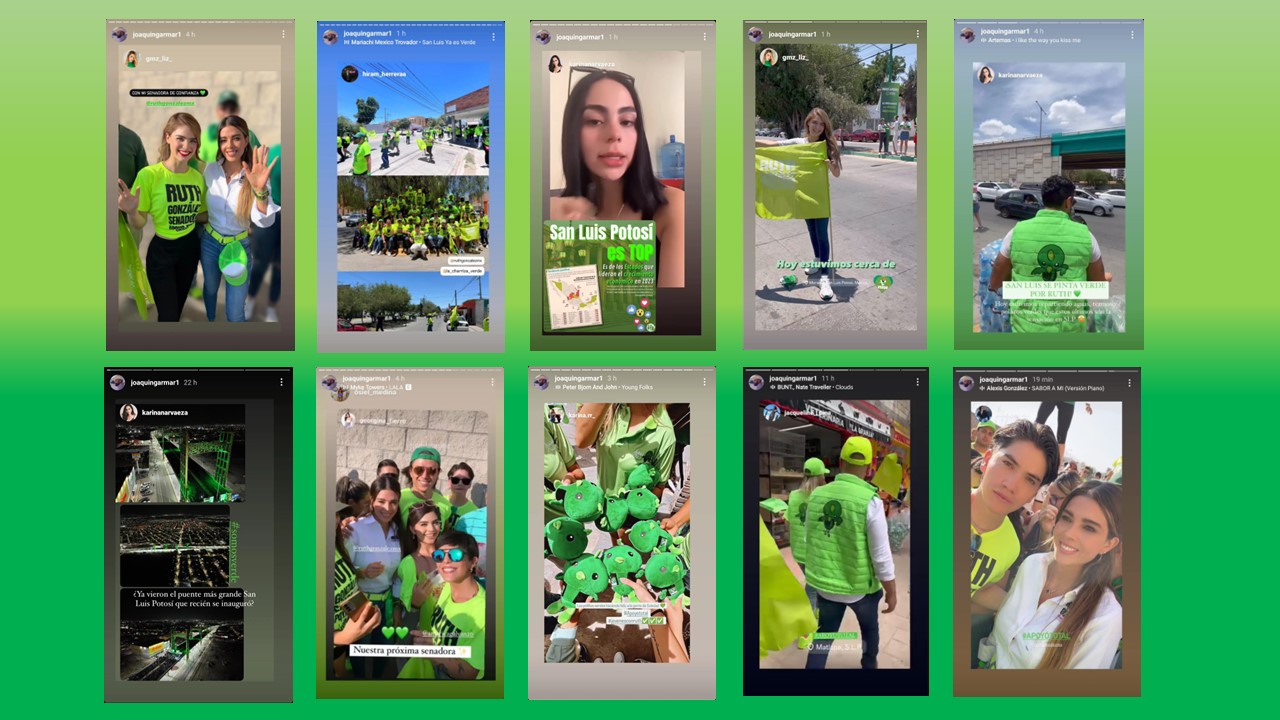

Puso como ejemplo el uso de deepfakes y noticias falsas en campañas electorales: en el caso de Brasil, “un candidato utiliza para atacar al otro candidato con noticias falsas que voy a utilizar como videos hechos por deepfakes”, mientras grupos de WhatsApp y Telegram facilitan la difusión masiva de información no verificada.

Durante su ponencia en el Salón de Plenos del Congreso, Florencio interactuó con estudiantes y asistentes a través de encuestas en línea para medir percepciones sobre la IA. La mayoría la percibe como potencialmente peligrosa y considera que los gobiernos no están preparados para regularla.

A partir de esos resultados, expuso que la IA es, al mismo tiempo, una oportunidad y un riesgo: puede mejorar trámites, atención ciudadana, servicios públicos y análisis de datos, pero también generar vigilancia masiva, pérdida de privacidad, dependencia tecnológica e impactos en el empleo si no hay estrategias de capacitación y reconversión laboral.

En el contexto latinoamericano, explicó que Colombia fue pionera en la discusión y que “Brasil ya tiene dentro de Latinoamérica los países que más están en este caso avanzando”, con aplicaciones en justicia y sistema electoral.

En contraste, sostuvo que “México camina lento, pero ve eso como agencia”, y puso como ejemplo, San Luis Potosí, que “hizo una reforma en la ley penal mostrando ya que puede afectar” cuando la IA se usa para dañar a otras personas.

Aun así, insistió en que la región no puede quedarse atrás y debe “crear leyes también, normalizar, regular para que tampoco alguien que utiliza la inteligencia artificial puede entonces heredar un daño a otro y que no haya una penalización”.

Consultado sobre la tensión entre la libertad de expresión y la regulación de contenidos generados o manipulados con IA, Florencio fue enfático en que el derecho a opinar tiene límites cuando se sustituye la realidad por falsedades.

“La libertad de expresión no puede también rebasar la cuestión de la ley”, sostuvo.

Aclaró que la libertad es compatible con el uso de IA siempre que haya veracidad y responsabilidad.

“¿En qué momento yo puedo seguir utilizando mi libertad de expresión con datos que no son reales? Entonces creo que eso es muy importante también tener la ética presente”.

El investigador también subrayó la necesidad de que los gobiernos garanticen transparencia de datos y acceso público a la información oficial como condición para que la ciudadanía pueda verificar versiones y detectar manipulaciones.

Reconoció que en muchos países “podemos manipular datos” desde el poder, por lo que es indispensable que exista “transparencia de la información y que sea pública para las personas que quieran consultar”. Sin ese piso mínimo, se vuelve muy difícil discernir qué es verídico y qué no en un entorno donde la IA permite fabricar discursos, cifras e imágenes creíbles.

En su repaso de ejemplos internacionales, Florencio habló de deepfakes del papa Francisco, de Donald Trump y de casos virales donde se manipulan fotografías o videos para engañar a la opinión pública, así como de abogados y jueces que han usado ChatGPT en decisiones judiciales sin verificar fuentes.

Para el ámbito educativo, alertó que muchos estudiantes elaboran trabajos completos “únicamente con ChatGPT” u otros modelos generativos, lo que obliga a universidades y docentes a repensar sus métodos de evaluación, sus reglas sobre plagio y sus políticas de integridad académica.

El ponente retomó la idea de que la IA en el sector público es “una promesa y una advertencia”: si se orienta al bienestar, puede fortalecer la eficiencia administrativa, mejorar la planificación urbana, la prevención de epidemias y la gestión ambiental; si se deja sólo en manos del mercado y de grandes corporaciones, puede concentrar poder, profundizar brechas y erosionar la confianza democrática.

Por eso, insistió, el primer paso es “abrir el debate público, que la gente participe, que los expertos expongan”, y sólo entonces avanzar a marcos regulatorios que combinen ética, derechos humanos y responsabilidad tecnológica.

Este encuentro marcó la primera ponencia del foro de dos días organizado por el Congreso del Estado para abrir un debate público sobre la regulación ética de la inteligencia artificial.